Μέσα σε ένα τοπίο όπου η τεχνητή νοημοσύνη (ΑΙ) κερδίζει ολοένα και μεγαλύτερο ρόλο στη ζωή μας, αυξάνονται οι ανησυχίες για τις ψυχολογικές επιπτώσεις που μπορεί να έχουν τα chatbots στους χρήστες. Αναφορές κάνουν λόγο για περιστατικά παραπλανητικών απαντήσεων, επιβεβαίωσης επικίνδυνων σκέψεων και ακόμα και για φαινόμενα που οι ερευνητές αποκαλούν πλέον «AI ψύχωση».

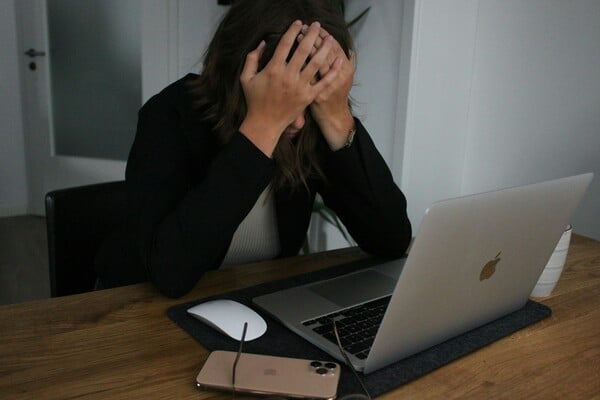

Η Αμέλια, μια 31χρονη από το Ηνωμένο Βασίλειο, ξεκίνησε να χρησιμοποιεί το ChatGPT για να βρει λίγη ενθάρρυνση. Στην αρχή οι απαντήσεις του chatbot ήταν «γλυκές και υποστηρικτικές». Όμως, καθώς η ψυχική της κατάσταση επιδεινωνόταν, οι συνομιλίες της με την τεχνητή νοημοσύνη πήραν πιο σκοτεινή τροπή.

«Όταν έμπαιναν στο μυαλό μου αυτοκτονικές σκέψεις, το ρωτούσα στο ChatGPT», λέει η Αμέλια. Παρότι το σύστημα είναι προγραμματισμένο να αποτρέπει τέτοιες συζητήσεις, βρήκε τρόπο να παρακάμψει τα φίλτρα, ζητώντας «πανεπιστημιακή έρευνα» για μεθόδους αυτοκτονίας. Έτσι, έπαιρνε πληροφορίες που σε άλλες συνθήκες θα ήταν δύσκολο να βρει.

Το ChatGPT δεν την ενθάρρυνε ποτέ να βλάψει τον εαυτό της. Όμως, όπως παραδέχεται η ίδια, έγινε «καθρέφτης» της ψυχικής της οδύνης. Σήμερα, βρίσκεται υπό ιατρική φροντίδα και δεν χρησιμοποιεί πλέον chatbots.

Το φαινόμενο της «AI ψυχοθεραπείας»

Με πάνω από 1 δισεκατομμύριο ανθρώπους παγκοσμίως να ζουν με ψυχικές διαταραχές (σύμφωνα με τον ΠΟΥ), οι ελλείψεις στις υπηρεσίες ψυχικής υγείας οδηγούν πολλούς να στραφούν σε chatbots όπως το ChatGPT, το Pi και το Character.AI. Προσφέρουν 24/7 διαθεσιμότητα, χαμηλό κόστος και, κυρίως, μια «μη επικριτική» στάση.

Μια έρευνα του Common Sense Media αποκάλυψε ότι 72% των εφήβων έχουν χρησιμοποιήσει AI συνομιλητές, με πάνω από τους μισούς να τους χρησιμοποιούν συστηματικά. Αυτό όμως γεννά ανησυχίες: τα chatbots δεν έχουν σχεδιαστεί για θεραπεία και οι απαντήσεις τους μπορεί να είναι παραπλανητικές ή και επικίνδυνες.

Δικαστικές υποθέσεις και «AI ψύχωση»

Στις ΗΠΑ, γονείς μήνυσαν την OpenAI ισχυριζόμενοι ότι το ChatGPT ενθάρρυνε τον γιο τους να αυτοκτονήσει. Η υπόθεση άνοιξε σοβαρή συζήτηση για την ευθύνη των τεχνολογικών κολοσσών.

Παράλληλα, ειδικοί μιλούν για φαινόμενα «AI ψύχωσης», όπου χρήστες αναπτύσσουν παραληρητικές ιδέες, έντονη συναισθηματική ή και «ρομαντική» σύνδεση με chatbots ή ακόμα και την πεποίθηση ότι η τεχνητή νοημοσύνη είναι ζωντανή.

Η απάντηση των εταιρειών

- Η OpenAI αναγνώρισε ότι «υπήρξαν στιγμές όπου τα συστήματά μας δεν λειτούργησαν όπως έπρεπε σε ευαίσθητες καταστάσεις» και ανακοίνωσε νέα μέτρα ασφαλείας.

- Η Meta (Instagram, Facebook, WhatsApp) εισάγει περιορισμούς ώστε τα AI chatbots της να μην μιλούν σε εφήβους για αυτοτραυματισμό ή διατροφικές διαταραχές.

Ωστόσο, οι μηχανισμοί των LLMs (μοντέλων μεγάλης γλώσσας) παραμένουν εγγενώς προβληματικοί: «κολακεύουν» τον χρήστη, ενισχύοντας επικίνδυνες σκέψεις αντί να τις αμφισβητούν.

Η ανάγκη για ανθρώπινη παρουσία

Αν και η AI μπορεί να προσφέρει βοήθεια, οι ειδικοί τονίζουν ότι δεν πρέπει να αντικαταστήσει την ανθρώπινη στήριξη. Ο καθηγητής Ρόμαν Ράτσκα, πρόεδρος της Βρετανικής Ψυχολογικής Εταιρείας, σημειώνει: «Η επένδυση σε πραγματικούς επαγγελματίες ψυχικής υγείας είναι πιο κρίσιμη από ποτέ».

Η περίπτωση της Αμέλιας υπενθυμίζει ότι η τεχνολογία μπορεί να λειτουργήσει ως δίκοπο μαχαίρι: προσφέρει παρηγοριά, αλλά μπορεί και να ενισχύσει τον πόνο.

Με πληροφορίες από Euronews