Καθώς η ρομποτική γνωρίζει αλματώδη ανάπτυξη, και οι άνθρωποι εξαρτώνται ολοένα και περισσότερο από τις υπηρεσίες τους σε διάφορους τομείς, τα ρομπότ πρέπει να μάθουν εκτός από πειθήνια όργανα να λένε "όχι" και να αρνούνται εντολές με βάση τους ανθρώπινους κώδικες επικοινωνίας. Ιδίως όταν οι εντολές που τους δίνουν οι χειριστές τους ενδέχεται να προκαλέσουν κακό ή τους αποσπούν από την εκτέλεση του έργου τους.

Όμως κάτω από ποιές συνθήκες και με ποιούς τρόπους επιτρέπεται σε ένα ρομπότ να αντιμιλά στον άνθρωπο;

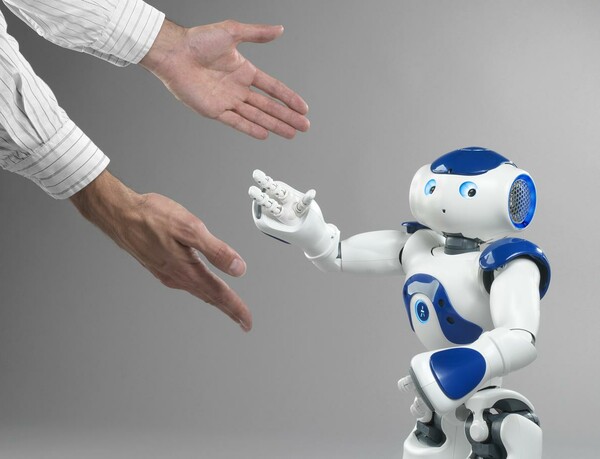

Οι ερευνητές Gordon Briggs και Matthias Scheutz του τμήματος αλληλεπίδρασης ανθρώπων και μηχανών του Πανεπιστημίου του Tufts, χρησιμοποιώντας το ανθρωπόμορφο ρομπότ Nao, προσπαθούν να διδάξουν ηθική και τρόπους στα ρομπότ και να τους εμφυσήσουν την αίσθηση του πότε και του πώς θα πρέπει να αρνηθούν τις ανθρώπινες εντολές, χρησιμοποιώντας έναν περίπλοκο αλγόριθμο.

Το "χαριτωμένο" αποτέλεσμα παραπέμπει μεν σε ταινίες επιστημονικής φαντασίας, αλλά είναι και μια πρόγευση από το κοντινό (για κάποιους "ζοφερο") απτό μέλλον της τεχνητής νοημοσύνης, που ήδη τίθεται σε εφαρμογή σε εφευρέσεις όπως τα αυτο-οδηγούμενα οχήματα, όπου οι μηχανές ίσως θα κληθούν να πάρουν αποφάσεις ζωής και θανάτου.

Researchers are teaching this robot how to reject our orders. The results are ominously cute.

Posted by Quartz on Tuesday, November 24, 2015

σχόλια